基于机器学习的强数据算法模型,这类模型常常用作回归和分类预测,完全基于数据计算得出结论,数据量大和质量好会得到很有效的结论,是现在使用越来越多的模型。

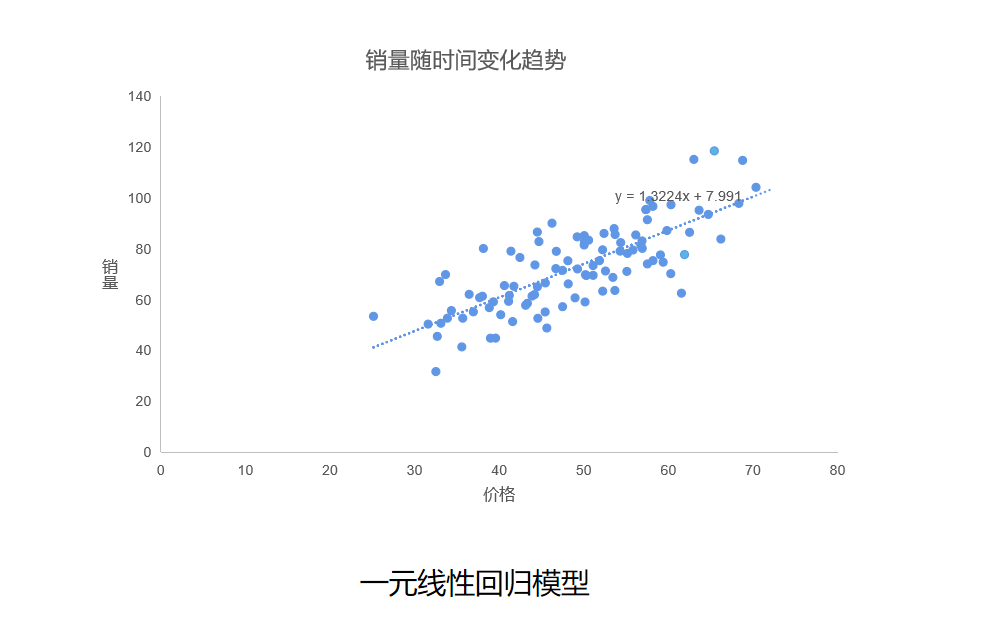

21.线性回归模型(linear Regression,LR)

线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛。其表达形式为y = w\'x e,e为误差服从均值为0的正态分布。通过最小二乘法或者梯度下降法求解出系数矩阵,从而得到线性回归方程来对新样本进行预测。线性回归模型与线性规划模型有什么区别呢?其实都是在求线性方程表达式,但是应用对象不同、求解目的不同。

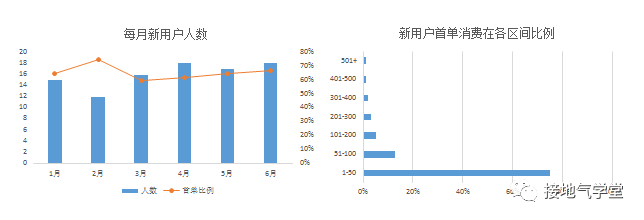

上面这个模型表示的是通过图上的数据(过去数据)来拟合一个线性回归表达式,如果给你新的数据x,可以通过这个表达式预测出y是多少。

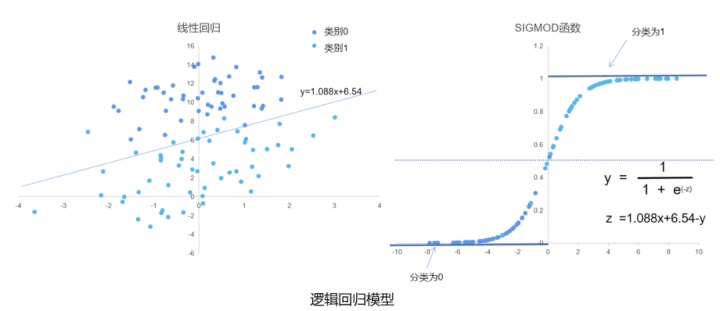

22.逻辑回归(Logistic Regression, LR)模型

逻辑回归模型是在线性回归的基础上加了一个激活函数SGMOID,使得原本回归求得的结果缩小到(0,1)之间,从而实现分类预测的作用。

从上面左图可以看到深蓝色点代表类别为0,浅蓝色点代表类别为1,虽然我们将这些点画出散点图也通过颜色知道它的类别,但是我们用什么标准还衡量它为什么为0或1呢?如果来了新的点怎么预测他的类别呢?靠直观感受是不行的,因此用数学表达式来作为衡量模型:

第一步,对左边的数据点拟合一个线性回归表达式;

第二步,将表达式整理变换得到z,再将z带入到SIGMOD函数(也叫激活函数)中,得到0到1之间的值,将这个值看作概率,离1越近表示越有可能分类为1,离0越近表示越有可能分类为0。

其实用左图直观感受可知直线上方的点离直线越远,它被分为1或0的证据就越强烈。

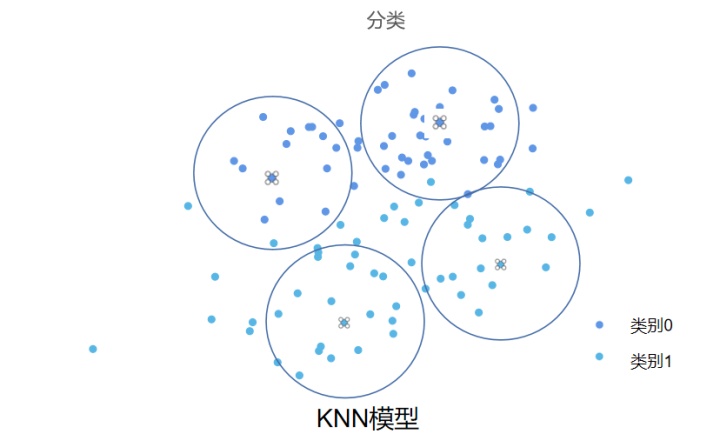

23.KNN模型(K个最近邻nearest neighbor)

KNN模型的模型思想可以简单归结为“物以类聚,人以群分”,上面逻辑回归对分类不同的点通过SIGMOD函数来区分。而这个模型则是通过点与点之间距离远近来区分。对上面同一批数据点用KNN来划分:

第一步,先选取n个中心点(一般有多少个类选多少个,当然也可以选择多个,这里选4个),计算所有数据与这四个点的距离;

第二步,将每个距离从大到小排序,越大离这个点近,越有可能跟这个中心点类别相同,我们就把中心点的类别赋值给这个点。但是不是简单通过一个中心点判断,你可以选择K个离它最近的中心点,采用投票法或平均法得出它的类别。

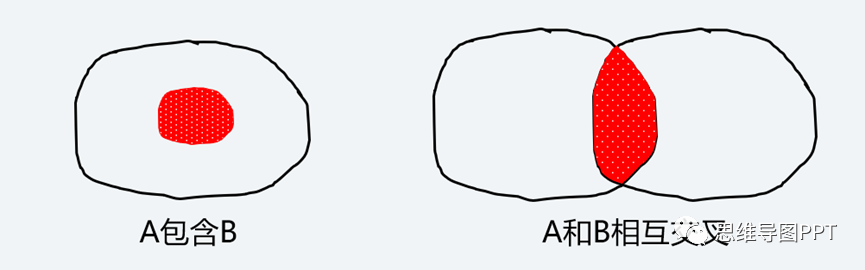

上面的图表名,KNN把大部分点都能分对,但是对处于两圆交界或者异常点区分能力很差。所以在实际分类建模时一般效果不如逻辑回归。

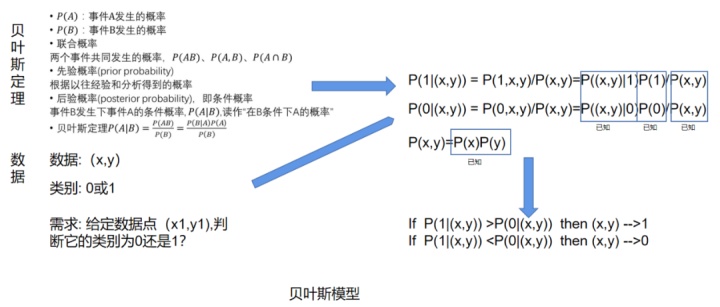

24.贝叶斯模型(Bayes)

这是来自统计学的数据分析模型,基于著名的贝叶斯定理。在我们日常做决策的时候,往往都会有这样一种感觉,当我对问题一无所知的时候,对做决策毫无把握,全靠猜,但是给了你一些信息之后,你对某个答案的把握就大一些。但是怎么衡量你的把握大小呢?贝叶斯定理说的就是你这个做决策过程的量化。

这个模型没有明确的表达形式,它依据的就是图上的贝叶斯定理公式。它主要应用于随机变量x,y为离散型变量。

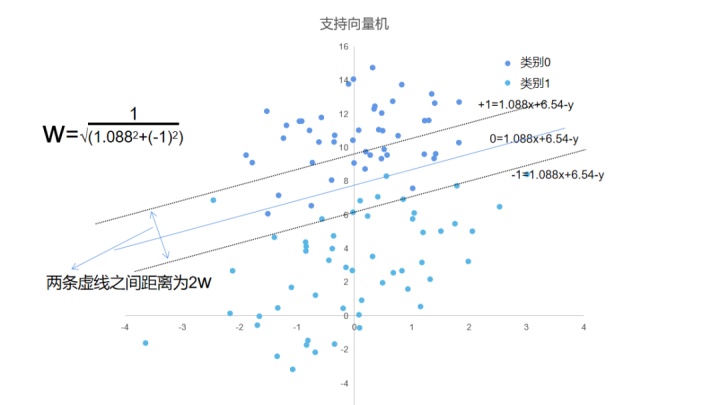

25.SVM模型(支持向量机,support vector machine)

这是来自数学领域的数据分析模型,是计算复杂度、理解复杂度都很高的模型。

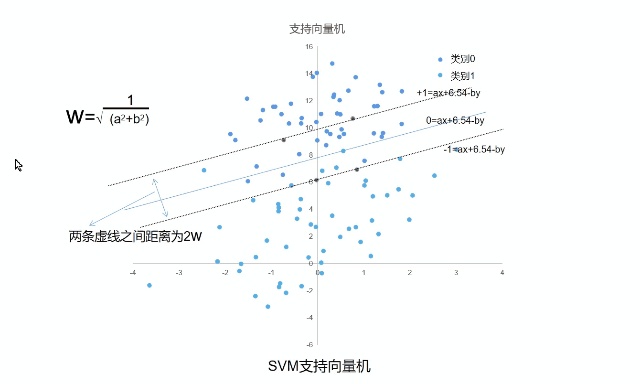

与线性回归一样,都是求出一条直线作为分割线,但是这个表达式的求解不是用线性回归的方式,这里的系数(1.088,-1)也是错误的,实际是未知的,可以用(a,b)代替;它也像线性规划问题,需要同时满足约束条件才能求出系数,但是又不是简单的线性约束。

那它是怎么求出这个表达式的系数(a,b)呢?,实际上是通过计算离分割线最近的点,使得这些点到分割线的距离之和最大,上面的图可以看到计算点到直线的距离就是关于系数(a,b)的函数。为什么要使得这些点到分割线的距离之和最大?这些点是哪些点?

上面这张图可以看到,从分割线1到分割线3,随着分割线的不断移动,点到直线的距离之和越来越小(图上可能不直观但是实际计算可知),但是分类的错误数却是在增加的,这说明在这个二维平面上有很多可以将这些点分隔开的线,但是把点尽可能多的分开的线只有一条,那就是点到直线的距离之和最小的直线,而这些点叫支持向量,它们是在计算过程中不断迭代找到的。

实际上后面的求解过程还很复杂,在这里无法一一解释清楚,感兴趣的可以进一步了解。通过与前面几个分类模型相比,你也可以看到它不仅找出分割线,还力求找到最佳的那一条,因此它在深度学习模型研究大火之前是最佳数据挖掘模型之一。

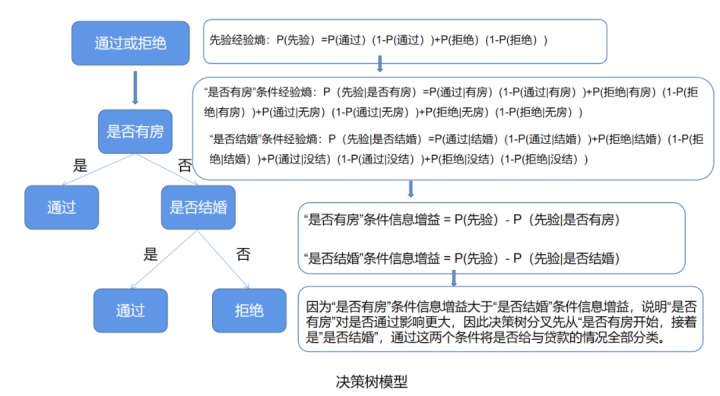

26.决策树模型(decision tree,DT)

决策树模型的使用的原理跟贝叶斯定理很像,但是它使用的不是条件概率而是条件经验熵,它也不是像贝叶斯模型那样一次性求出所有条件概率乘积,得到结果为1的概率和结果为0的概率,两者相比较,而是一步一步筛选哪些条件是最有效的,其次是哪个,无效的条件就丢掉,这样既提高准确率,也提高效率。这跟我们的决策行为也是相符的,虽然我们从一无所知到知道一些信息,但是对这些信息也需要加以甄别,哪个是对结论支持最有力的证据才使用哪个。

可以看到决策树模型和之前的决策树七步法思考方式有相似性,都是一步一步判断得到最终结论,但是前者是感性判断,这里是通过数值计算。

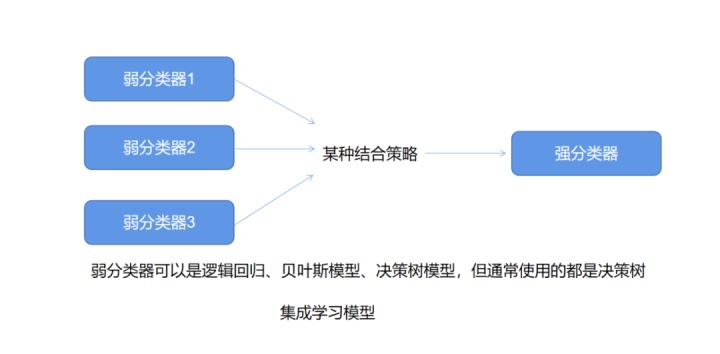

27.集成学习模型(ensemble learning,EL)

集成学习模型实际上不是具体算法,而是一种策略,是在前面几种模型基础上集合而成的,前面都是单个模型,而集成学习就是将多个单模型放在一起进行分类预测。俗话说就是:“三个臭皮匠定个诸葛亮”。一个单模型可能预测不准,但是多个模型通过投票或者平均,就能提高分类准确率。集成模型也是在深度学习模型研究大火之前是最佳数据挖掘模型之一。

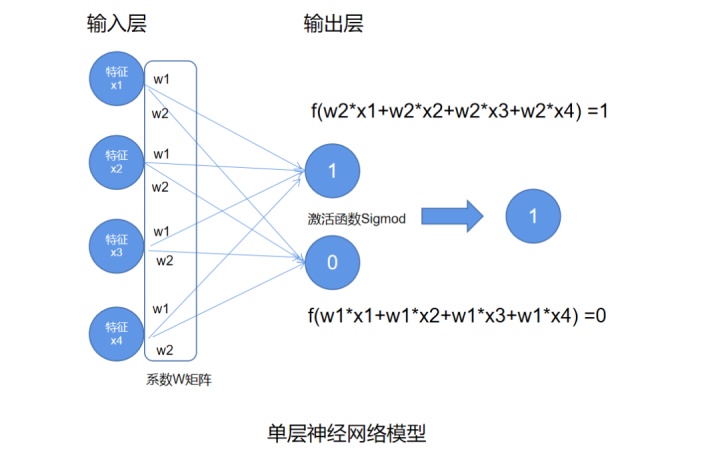

28.神经网络模型(neural network,NN)

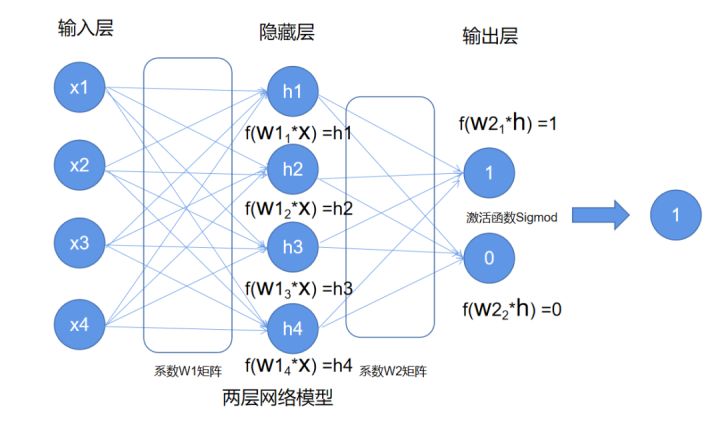

神经网络模型源自计算机科学家对生物学领域的神经网络得到的启发,人类大脑有着复杂的神经网络,每个神经元连着很多神经,当脑子有一个想法会产生电信号,电信号在神经中传导到达神经元经过神经元细胞的处理转化得到另一个信号再通过神经网络传给下一个神经元,这样一层一层传递就能调动身体各部分配合来完成动作。

因此,神经网络把每个因素(又叫特征、随机变量,就是前面例子说的x,y)当做电信号,系数矩阵当做传导神经,激活函数当做神经元。如下图:

可以看到三层神经网络跟逻辑回归模型很像,可以把逻辑回归模型看作是单层神经网络来理解,多层神经网络就是不断增肌神经元,扩大系数矩阵。逻辑回归模型我们是要得到一个系数a和偏值b,但是我们要得到的神经网络模型,就是得到很多个a和b,叫做系数矩阵W,有了系数矩阵W就固定了表达式形式。神经网络模型的形式是曲线。不像线性回归,它可以更好的拟合所有数据,从而达到更准确的分类。